→ somerabbit : 工作上一個ticket 用了cursor + o1 preview, 1個小 09/18 11:30

→ somerabbit : 時就做完了 答案還很完美。 令人驚艷的是它可以快 09/18 11:30

→ somerabbit : 速閱讀很多files 然後思考 並準確的給出答案 09/18 11:30

推 OyodoKai : 現在報名水電學徒還來的急嗎 09/18 11:33

→ zxwxz : 我覺得Orion 出來之後可能是agent 完整體,到時可 09/18 11:34

→ zxwxz : 能不用外掛任何寫code框架就可以搞定 09/18 11:34

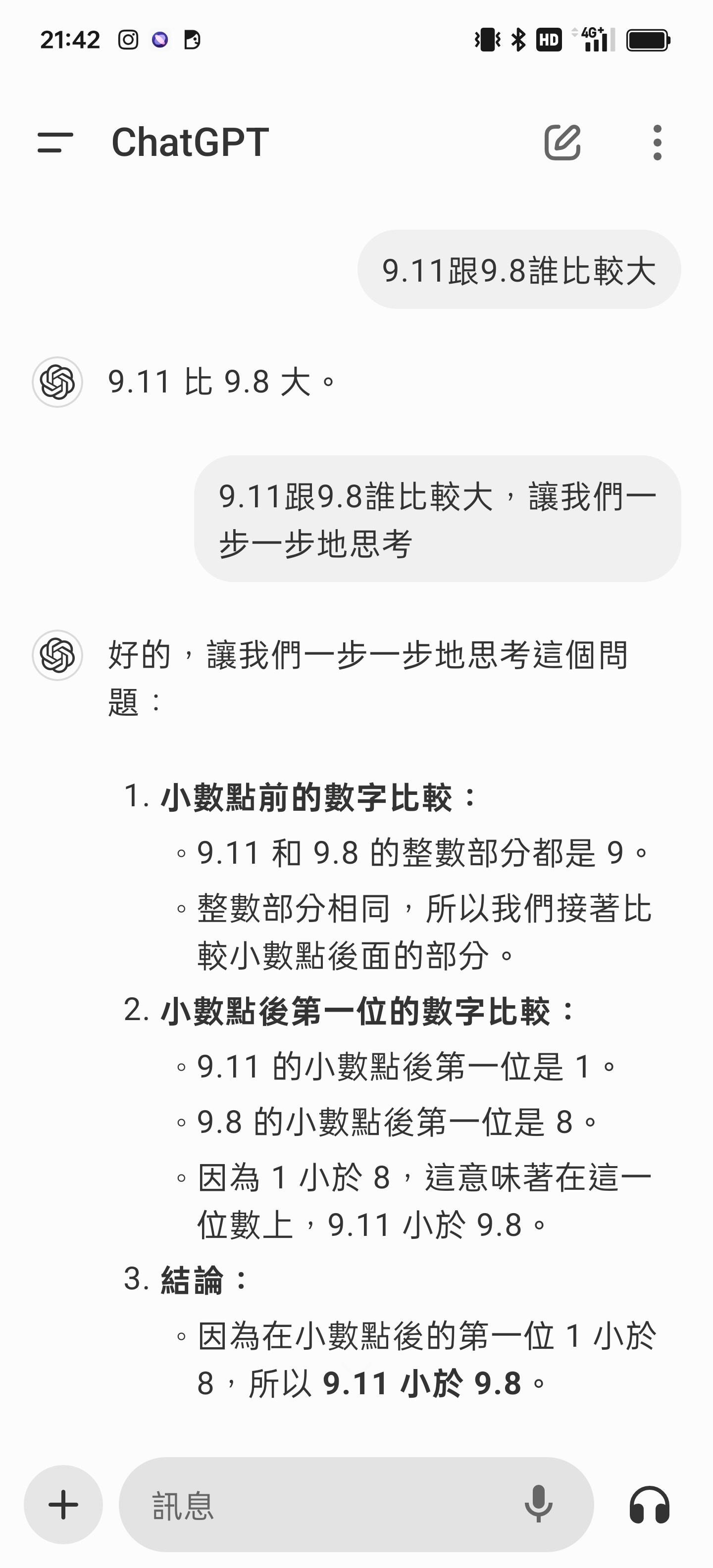

→ ma721 : 9.9 vs 9.11 09/18 11:35

→ zxwxz : 9.9 vs 9.11還有幾個r在strawberry 中都屬於token 09/18 11:44

→ zxwxz : 切割的蠢問題,不會是o1要處理的重點,覺得AI很愚 09/18 11:44

→ zxwxz : 蠢的可以繼續開心很多年 09/18 11:44

推 HiHiCano : 樂見Ai取代人類 不然每天工作好累 09/18 11:50

→ fallcolor : 讓llm出題做rl很合理,可是給reward的 label從哪來 09/18 11:52

→ fallcolor : 呢? 如果還是需要人為prompt介入,本質上不算agi 09/18 11:52

→ fallcolor : 吧 09/18 11:52

推 NTHUlagka : 真的 未來那些system design跟軟體開發上的know ho 09/18 12:02

→ NTHUlagka : w, gpt會也只是時間上的問題了 現在報名水電還來得 09/18 12:02

→ NTHUlagka : 及嗎 感覺SWE的生存空間要被壓縮了QQ 09/18 12:02

→ zxwxz : 新的rl已經不需人類介入,不是rlhf。你要仔細參考 09/18 12:03

→ zxwxz : 我貼的那篇才知道可能的做法,以下僅是個人猜測, 09/18 12:03

→ zxwxz : 一開始應該會先以gan為基底方法,有題目有答案但沒 09/18 12:03

→ zxwxz : 有cot,訓練時要求llm提供完整cot,然後把每步驟的 09/18 12:03

→ zxwxz : cot都拆解成獨立證明提要求critic llm把關,如果證 09/18 12:03

→ zxwxz : 明看不懂就得要求o1往下拆解到critic llm看得懂且 09/18 12:03

→ zxwxz : 置信率要非常高。等到這步訓練有成效之後,再請出 09/18 12:03

→ zxwxz : 題o1出題給解答o1解,這時會依照既有知識堆疊出一 09/18 12:03

→ zxwxz : 個複雜的長尾問題出來讓o1自己解,進而不用再抓取 09/18 12:03

→ zxwxz : 網路大量垃圾來訓練model,資料牆問題也被攻克 09/18 12:03

→ zzzxxxqqq : 9.9 vs 9.11 真的不重要.. 隨便想想都知道 09/18 12:22

→ zzzxxxqqq : 隨便想像都知道 10年後有多可怕 -.- 09/18 12:23

→ jeff85898 : 對模型做rl跟在prompt內加入CoT的差別是? 09/18 12:28

推 kunyi : 好喔 09/18 12:35

→ zxwxz : 在RL做COT與在PROMPT做COT有非常本質上的問題,就 09/18 12:56

→ zxwxz : 是要如何驗證COT是對的,你請gpt-4o 在複雜的數理 09/18 12:56

→ zxwxz : 問題上做COT,他常常可以回個大概,但中間有步驟錯 09/18 12:56

→ zxwxz : 了或是太含糊,根本上COT本身會有非常嚴重的幻覺問 09/18 12:56

→ zxwxz : 題,但你如果把COT拆解成一段一段讓critic llm去解 09/18 12:56

→ zxwxz : ,那中間是否有問題就很容易判定,再者有些說明跳 09/18 12:56

→ zxwxz : 太快critic llm可能無法從先驗知識解讀,那就要進 09/18 12:56

→ zxwxz : 一步請o1做問題拆分。 這單靠prompt是無法解決的, 09/18 12:56

→ zxwxz : 我猜目前o1的一次推理中的cot中每個step都是一次單 09/18 12:56

→ zxwxz : 獨的inference ,當然還要配套MTCS,不然你會很容 09/18 12:56

→ zxwxz : 易陷入長尾問題的local minimum 中 09/18 12:56

→ zxwxz : 更正 是MCTS 09/18 12:58

→ fallcolor : 也許可行吧,只是就算把cot分解critic要判斷的還是 09/18 13:02

→ fallcolor : 比alphago的critic估計勝率難很多,label品質不好 09/18 13:02

→ fallcolor : 就不容易是一種穩定的訓練方法。 09/18 13:02

→ zxwxz : 我覺得可以可以讓critic llm逐漸使用高置信率來評 09/18 13:08

→ zxwxz : 斷進而推升o1本體的能力,那每個cot可能就從對5個 09/18 13:08

→ zxwxz : 晉升到對10個,進一步推升到整個chain都是對的。所 09/18 13:08

→ zxwxz : 以o1可以不用一次inference對整串,他要確保的是在 09/18 13:08

→ zxwxz : 每一個step正確性以及前後連貫性,如此就沒有梯度 09/18 13:08

→ zxwxz : 消失的問題 09/18 13:08

推 qwe78971 : 太樂觀 離AGI還遠的 三維空間問題它沒辦法處理 09/18 13:11

推 gogogogo3333: AGI is clearly here. But fine … Don’t look up. 09/18 13:31

→ zxwxz : 三維空間無法解決的請看這鏈結 09/18 13:43

→ qwe78971 : 蠻厲害的 不借助引擎完成 不過我是指real world 09/18 13:49

→ zxwxz : 這次突破的關鍵可以看這個openai關鍵員工的演講: 09/18 13:50

推 aria0520 : stop the hype train, LLM is a dead end 09/18 14:01

→ aria0520 : don't waste time on llm, go4 lecun's world model 09/18 14:01

推 sdbb : 難得的優文,謝謝 09/18 14:05

推 fallcolor : 讀了論文,關鍵是讓小模型指導大模型是放大模型更 09/18 14:23

→ fallcolor : 好的泛化性,相當於用模型的先天表示力去補強標籤的 09/18 14:24

推 steak5566 : 請問現在開始練身體可以當比較有用的生物電池嗎? 09/18 14:25

→ Izangel : 三維不就李飛飛正在做的嗎 09/18 14:25

→ fallcolor : 先驗了,好像有點道理。 09/18 14:25

→ fallcolor : 改個錯字,釋放。 09/18 14:27

推 lafel : 還有幾個月可以逃呢 09/18 15:08

推 tomatobus : 嘻嘻,結果工程師吹了半天AI取代醫生,自己的工作先 09/18 15:16

→ tomatobus : 被取代 09/18 15:16

→ zxwxz : 不用逃了,即使是完整o1都算閹割版,他們內部大概 09/18 15:16

→ zxwxz : 率已經有AGI level 4完整版在玩了,放不放出來只是 09/18 15:16

→ zxwxz : 安全性評測與性價比問題 09/18 15:16

→ houseguy : 什麼時候能發現新的微分方程有解析解的 09/18 15:45

推 kkithh : AIME題目好像都可以用暴力硬解,用這來說AI比人厲害 09/18 16:07

→ kkithh : ,欸豆,頂多說它算得快吧 09/18 16:07

推 steak5566 : 可以reasoning代表所有人類講邏輯的東西都可以取代 09/18 16:21

→ steak5566 : 大概只剩律師法官? 09/18 16:21

推 lantimes : 還好 錢 房子都存夠了 09/18 16:57

→ wtl : 所以小氣公司真的可以用AI來縮減一半的人力? 09/18 17:07

推 transforman : 瑟瑟發抖 現在考水電還來的及嗎 09/18 17:10

→ DrTech : 想太多了,目前所有測試LLM方式都是在"有標準答案" 09/18 17:14

→ DrTech : 的情況。現實工作中,明明大部分的工作都是每標準答 09/18 17:14

→ DrTech : 案,甚至看人心情的情形。 09/18 17:14

→ DrTech : 沒標準答案的工作,AI要怎麼訓練與幫助你工作。 09/18 17:18

→ DrTech : 目前的標準答案形式的AI,工廠的瑕疵檢測都解不了了 09/18 17:20

→ DrTech : 。 09/18 17:20

→ DrTech : 連最基本的電子產品生產環節,任何一個製程發生issu 09/18 17:22

→ DrTech : e,怎麼依照現場環境來出解答(一直都難以有標準答案 09/18 17:22

→ DrTech : ),都做不了了。 09/18 17:22

→ DrTech : AI生成任何標準答案,是正確的沒錯,而且可能比人寫 09/18 17:27

→ DrTech : 的好,但不代表是現實工作可採用,可被接受的。 09/18 17:27

→ zxwxz : 現實不採用單純是cp值與先驗問題,這麼貴又還沒有 09/18 17:55

→ zxwxz : 人在商務上投產過,如果不能肯定創造更多價值或節 09/18 17:55

→ zxwxz : 省成本,沒有公司願意嘗試,但3年後我預估成本會比 09/18 17:55

→ zxwxz : 現在低100倍,且有實際成功案例,到時大失業潮就會 09/18 17:55

→ zxwxz : 來臨 09/18 17:55

推 Izangel : 蛋白質跟藥物合成的標準答案是什麼?笑死。怎麼總有 09/18 18:10

→ Izangel : 人把自己認為的就以為是AI的全部能力或定義? 09/18 18:10

→ tgyhuj01 : 同理 所以如何證明當下人類的判斷就一定是對的? 09/18 18:15

→ tgyhuj01 : 一直用AI只會照表抄課來否定 那一堆標準訂來讓人類 09/18 18:19

→ tgyhuj01 : 遵循的意義又是什麼 09/18 18:19

→ tgyhuj01 : 不能完全替代不代表不能部分替代 09/18 18:21

推 create8 : 感謝分享! 是時候去少林寺報名廚藝班了 09/18 18:48

推 sdbb : 食神梗太老了 09/18 18:49

推 hansioux : ARC-AGI 先對 85% 我再來擔心 09/18 20:39

推 utn875 : 感謝解說 09/18 20:45

推 create8 : 只要有心,人人都可以是食神!! (振奮 09/18 20:57

推 sdbb : 一切都是幻覺(AI也有),嚇不倒我的 09/18 21:00

推 spen2005 : Aime又不難 要說的話 deepmind還更強 09/18 21:08

推 alvinlin : 總是有需要人的地方。只是會有中空期。 09/18 21:26

推 likeyousmile: 推 09/18 22:55

→ kiedveian : 有人說到token切割不屬於它的問題,那是不是代表 09/18 23:03

→ kiedveian : 就算發展的再強,也會因為token切錯出大問題? 09/18 23:04

→ zxwxz : token切割單純是要節省算力,之後只要agent 掛上程 09/18 23:14

→ zxwxz : 式工具,這些都是小問題 09/18 23:14

→ rnoro : openai的報告真叫人唏噓,現在連一行方程式都看不到 09/18 23:26

→ rnoro : 了,要嘛實在太小氣,要嘛沒有數學上的新東西 09/18 23:27

→ rnoro : 不管是哪個都讓人失望。。。 09/18 23:27

噓 gsinin : 意識到嚴重性所以呢?你那邊還來得及買便宜的台積電 09/19 00:58

→ gsinin : 快買 09/19 00:58

→ strlen : 就是沒有標準答案才要靠AI啊 到底在說什麼啊 09/19 01:24

→ strlen : 去想想當人類碰到沒有標準答案的問題 是怎麼處理的 09/19 01:24

→ strlen : 很簡單 試阿 這裡試試 那裡試試 試到有一次打中問題 09/19 01:25

→ strlen : 點了就解了 哪一個沒標準答案的問題不是這種解法? 09/19 01:25

→ strlen : 那試東西 機器絕對比人類快一百萬倍吧 09/19 01:26

→ kissa0924307: 天網的原型? 09/19 01:51

推 hduek153 : 好期待人類被取代的那一天 十年內有機會嗎 09/19 07:26

→ chauan : 人是拿來負責任用的 09/19 08:44

→ darkangel119: 人類是拿來當電池 ~~ 09/19 10:28

推 jamesho8743 : 數學方面我覺得到最後不需要人來label AI是可以左 09/19 13:57

→ jamesho8743 : 右互搏來比較認證 09/19 13:57